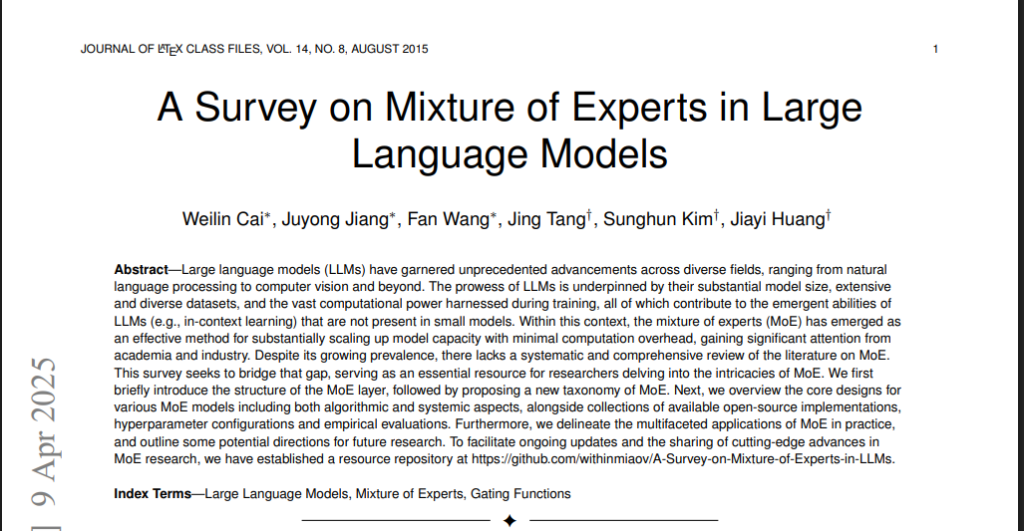

Mixture of Experts (MoE) нь машин сургалтын загваруудын нэг төрөл бөгөөд өндөр гүйцэтгэл, үр ашгийг хангах зорилгоор олон жижиг хэсэгчилсэн загваруудыг (experts) нэгтгэн ашигладаг архитектур юм. Энэ загвар нь том хэмжээний нейроны сүлжээнүүдийн тооцооллын зардлыг бууруулж, тодорхой даалгаварт илүү сайн тохируулан ажиллах боломжийг олгодог.

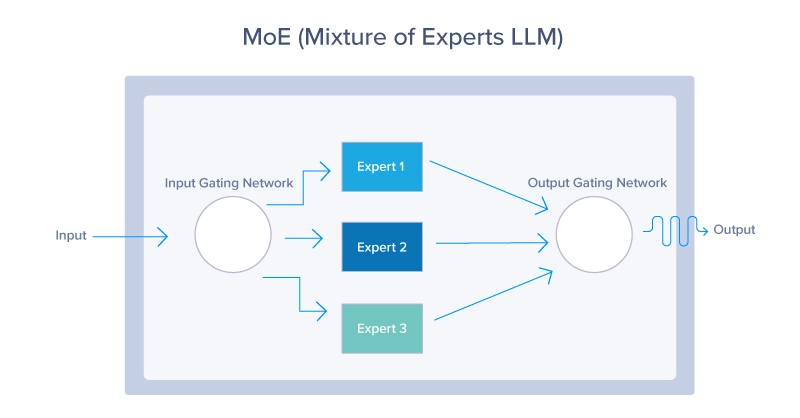

MoE загвар нь дараах гол бүрэлдэхүүн хэсгүүдээс тогтоно:

Экспертүүд (Experts): Эдгээр нь бие даасан жижиг нейроны сүлжээнүүд бөгөөд тус бүр нь өгөгдлийн тодорхой хэсэг буюу даалгаварт мэргэшсэн байдаг. Жишээ нь, нэг эксперт нь текст, нөгөө нь зураг боловсруулах чиглэлээр ажиллаж болно.

Хаалга (Gate): Хаалга буюу “routing” механизм нь өгөгдлийг ямар эксперт рүү илгээхээ шийддэг. Энэ нь ихэвчлэн softmax функцийн тусламжтайгаар өгөгдлийн онцлогт тохируулан экспертүүдийг сонгоно.

Нэгтгэх механизм: Экспертүүдийн гаралтыг нэгтгэж, эцсийн хариуг гаргадаг.

MoE-ийн гол давуу тал нь зөвхөн шаардлагатай экспертүүдийг идэвхжүүлснээр тооцооллын зардлыг бууруулж, загварын хэмжээг өсгөх боломжтой байдаг.

Техникийн хэрэгжүүлэлт

Жишээ нь өгүүлбэрийн өөр өөр хэсгүүдэд өөр өөр дүн шинжилгээ хийх шаардлагатай болох буюу хэлц үгийн утгыг ойлгох эксперт, дүрмүүдийг ойлгох эксперт гэх мэт нэг биш, олон эксперт хэрэг болох үед яах вэ?

1. Sparse Activation

MoE-ийн гол онцлог нь sparse activation буюу сийрэг идэвхжүүлэлт юм. Энэ нь бүх мэргэжилтнүүдийг хамтад нь идэвхжүүлэхгүйгээр зөвхөн хамгийн тохиромжтой хэдэн мэргэжилтнийг л сонгон ашигладаг.

2.Load Balancing

MoE системийн нэгэн чухал асуудал бол ачаалал тэнцвэржүүлэлт юм. Зарим экспертүүд хэт их ачаалалтай болж, бусад нь огт ашиглагдахгүй байх магадлалтай. Үүнийг шийдэхээр тусгай алгоритмууд хөгжүүлэгдсэн.

MoE Paper: https://arxiv.org/pdf/2407.06204

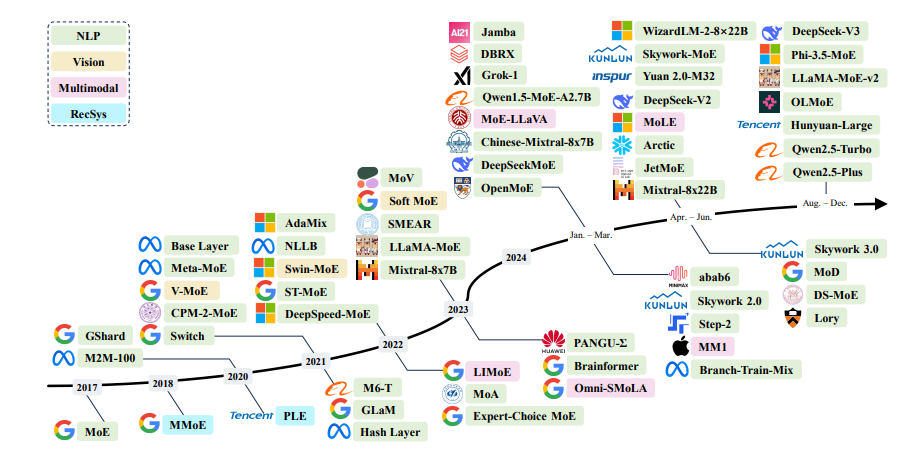

Практик хэрэглээ

1. Хэл боловсруулалт

- Google-ийн PaLM мodel

- OpenAI-ийн GPT-4 (MoE элементүүдтэй)

- Switch Transformer

2. Компьютер хараа

- Зураг таних системүүд

- Видео боловсруулалт

3. Multimodal

- Текст, зураг, дуу хоолойг хамтад нь боловсруулах системүүд

MoE Хэрэгжүүлэх Нээлттэй Модел

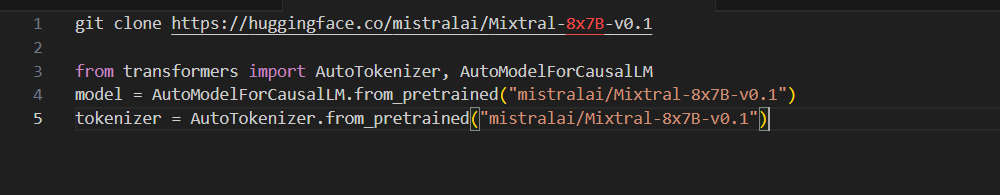

Mixtral 8x7B – Mistral AI

Mixtral 8x7B нь Apache 2.0 лицензтэй, Llama 2 70B-ээс 6 дахин хурдан, GPT-3.5-тэй адилхан гүйцэтгэлтэй

Онцлог:

- 8 эксперт× 7B параметр

- 32k token контекст

- 5 хэл дэмжинэ (англи, франц, итали, герман, испани)

- Зөвхөн 2 мэргэжилтэн идэвхжинэ(top-k)

Хайлт

Категори

- 1 минутын уншлага

- 2 минутын уншлага

- AI

- Algorithm

- Bиртуалчлал

- Competitive programming

- computer science

- ide

- webiste

- Аюулгүй Байдал (4)

- боловсрол

- Зөвлөгөө

- Инженерчлэл ба Технологийн Системүүд (2)

- Код

- Компьютерын Шинжлэх Ухаан ба Програмчлал (1)

- Крипто

- Математик

- Өгөгдөл ба Хиймэл Оюун Ухаан (3)

- Программ хангамжийн төсөл

- Систем

- Сурагчдад

- Тархи ба Код

- Технологи, Нийгэм ба Боловсрол (5)

- Технологийн түүх

- Тоглоом хөгжүүлэлт

- Хөндлөнгийн

- Электроник