Сүүлийн хэдэн жилийн турш гүнзгий сургалтын салбарт Transformer архитектур нь маш их анхаарал татсан, хүчирхэг загвар болон хөгжсөн. Ялангуяа хэлний загварууд дээр гайхалтай үр дүн үзүүлж, Google-ийн “Attention is All You Need” (2017) paper-аас хойш AI-ийн түүхэнд эргэлт гаргасан.

Энэхүү нийтлэлээр Transformer архитектур, блок болон attention-ий талаар өгүүлнэ.

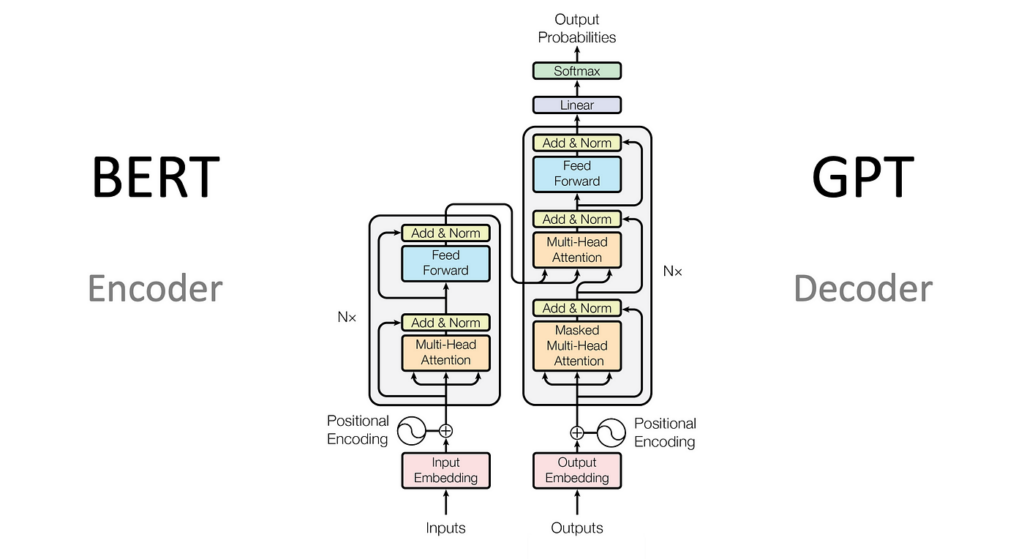

1. Transformer архитектур

Трансформерыг ялгаруулж чадсан нэг зүйл бол Attention юм. Энэ нь урьд нь хэрэглэгдэж байсан RNN (Recurrent Neural Network), LSTM (Long Short-Term Memory) зэрэг архитектуруудаас ялгаатай. RNN загварууд дараалалласан өгөгдлүүдийг ээлж дараалан боловсруулдаг бол Transformer нь бүх өгөгдлийг параллел буюу зэрэгцээ байдлаар боловсруулдаг нь сургалтын хурд болон үр ашигийг ихээр сайжруулсан.

Үндсэн блокууд

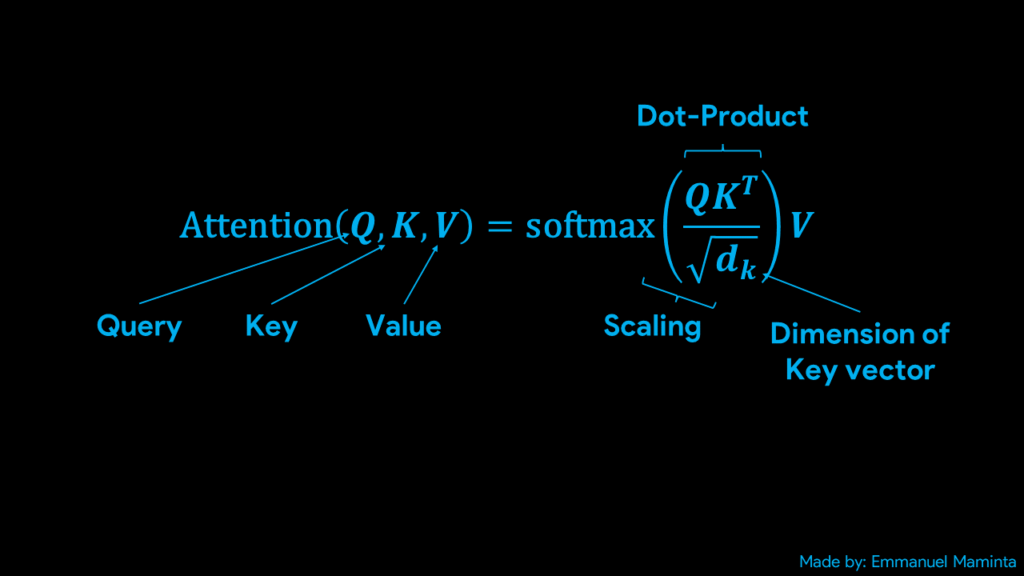

Self-Attention

Self-attention нь өгүүлбэрийн үг бүрийг бусад үгтэй , тухайн үгийн утгыг ойлгоход тусалдаг. Энэ нь Query (Q), Key (K), Value (V) гэсэн матрицуудаас тогтоно. Яаж тэгж байгаа вэ гэхлээр орж ирсэн асуулгын үгний векторууд бүрийн тус тусын хамаарлыг скаляр үржвэрээр олж хамаарлыг тодорхойлдогт байгаа юм. Эдгээр матрицуудыг нэг ёсны динамик жинтэй матриц гэж хэлж болно.

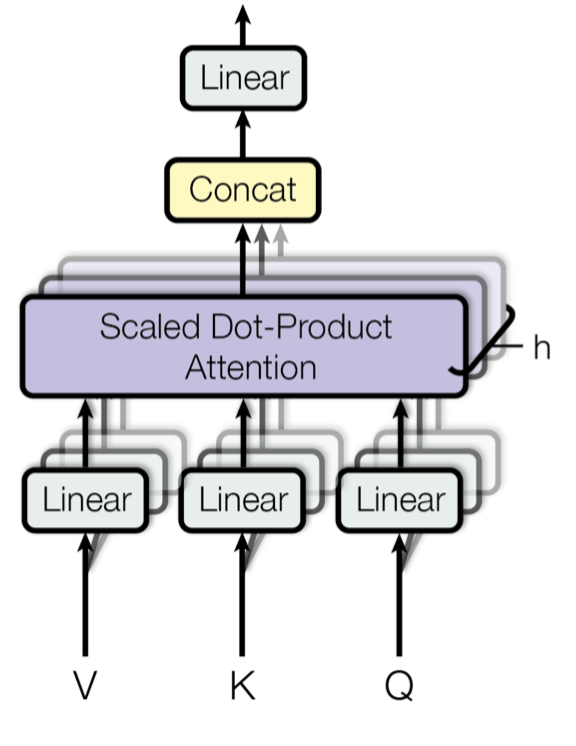

Multi-Head Attention

Self-attention-г илүү уян хатан болгохын тулд Multi-Head Attention ашигладаг. Энэ нь өөр өөр “анхаарал хандуулах замууд”-ыг зэрэг ашиглаж, илүү олон өнцгөөс өгөгдлийг ойлгоход тусалдаг.

Position-wise Feed-Forward Network

Анхаарлын үр дүнг нарийн боловсруулж, илүү өндөр төвшний дүрслэл гаргахын тулд feed-forward нейрон сүлжээ ашигладаг. Энэ нь байрлал тус бүрд ижил жинг ашигладаг бүрэн холбогдсон давхарга юм.

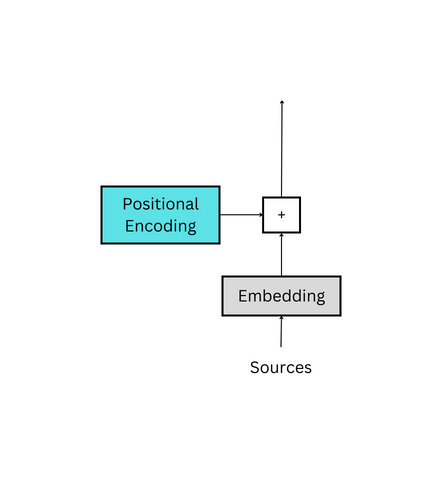

Positional Encoding

Transformer нь дарааллыг мэдэрдэг RNN шиг биш учраас Position Encoding ашиглан үгсийн дарааллын мэдээллийг векторт шингээдэг. Энэ нь синус, косинус функцээр байрлалыг кодчилдог.

Дүгнэлт

Transformer архитектур бол анхаарлын механизм дээр суурилсан, сүүлийн үеийн хамгийн нөлөө бүхий моделуудын архитектур юм. Энэхүү онолын үндэс нь зөвхөн хэл боловсруулалт гэлтгүй маш олон салбарт хэрэглэгддэг ажээ.

Дэлгэрэнгүй мэдэхийг хүсвэл доорх бичлэгээс хүлээн авна уу.